¿Tu organización ya utiliza modelos de IA o agentes inteligentes, pero no sabe exactamente quién los consume, cuánto cuestan realmente ni cómo establecer límites de seguridad en producción?

Si no se cuenta con un punto central de control, las llamadas a modelos se dispersan, los costes crecen de forma impredecible, la seguridad se debilita y la observabilidad desaparece.

El IA Gateway es una solución empresarial imprescindible en este contexto: una capa diseñada para gestionar, asegurar y optimizar la interacción entre aplicaciones, agentes y APIs de inteligencia artificial.

En este artículo veremos qué es exactamente un IA Gateway, qué problemas resuelve frente a un API Gateway tradicional, cuáles son sus beneficios más relevantes y qué plataformas y buenas prácticas permiten adoptarlo de forma segura en entornos modernos.

¿Qué es una puerta de enlace de IA o IA Gateway?

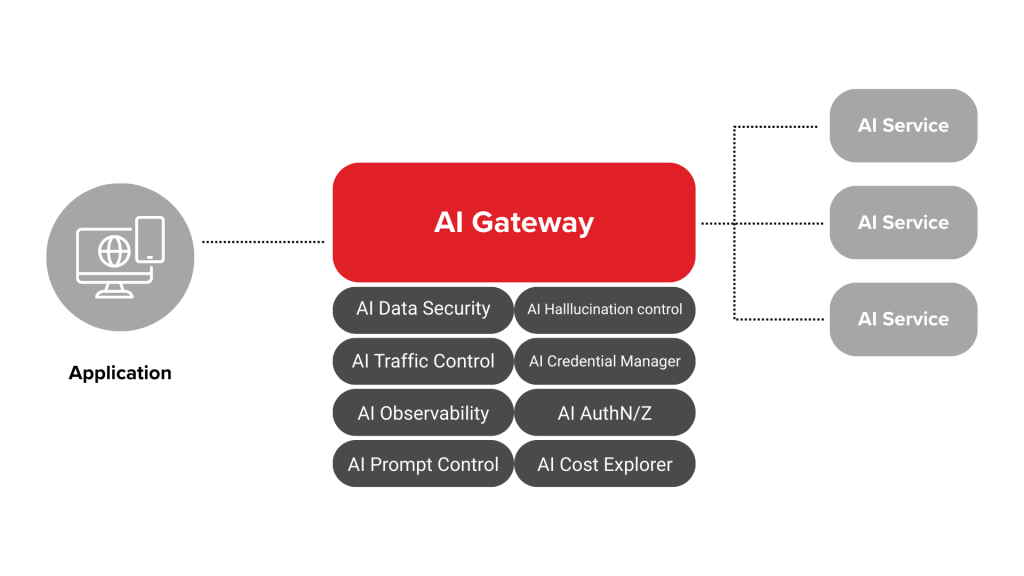

Un IA Gateway (también llamado puerta de enlace de IA) es una plataforma de middleware especializada que se posiciona como un punto centralizado de conexión, control y gestión entre aplicaciones y modelos de lenguaje (LLMs), APIs de IA y agentes inteligentes.

Así, su objetivo principal es simplificar y gobernar las interacciones con estos sistemas mediante una interfaz unificada, aplicando políticas de seguridad, control de acceso, enrutamiento inteligente, observabilidad y gestión de cargas de trabajo de IA.

AI Gateway

¿Qué hace específicamente un AI Gateway?

Un AI Gateway actúa como puente entre las aplicaciones de usuario y los distintos modelos de IA o servicios de inferencia que puedas tener desplegados (propios o de terceros), proporcionando las siguientes funciones:

- Integración y orquestación multinivel

Permite integrar múltiples modelos o servicios de IA sin que cada aplicación deba conectarse individualmente a cada proveedor, simplificando la arquitectura. - Seguridad y gobernanza centralizada

Aplica autenticación, autorización y políticas de uso coherentes en todos los puntos de acceso de IA. - Control de tráfico, observabilidad y métricas específicas de IA

Ofrece métricas de uso de tokens, errores y costes, además de funciones como almacenamiento en caché y limitación de velocidad (rate limiting), diseñadas para cargas de trabajo de IA. - Enrutamiento inteligente entre modelos y servicios

En ambientes con múltiples LLMs o instancias, puede dirigir las peticiones al modelo más adecuado según criterios de coste, latencia u otras políticas.

En contraste con un API Gateway, que se diseña para enrutar solicitudes API de propósito general (por ejemplo, REST o HTTP) y aplicar reglas básicas de seguridad y escalado, un IA Gateway maneja las características específicas de los workloads de IA, tales como el flujo de contextos, negociación de token quotas, enrutamiento semántico y políticas de gobernanza adaptadas a modelos de inteligencia artificial.

El siguiente artículo puede interesarte: Gestión de identidades IAM: beneficios y análisis de soluciones

Ejemplo

Imagina una aplicación de atención al cliente omnicanal (chat, email o WhatsApp) que usa distintos modelos de IA: uno para generar respuestas, otro para detectar sentimiento e intención, y otro para analizar imágenes (por ejemplo, una foto de un producto dañado o un comprobante).

Un IA Gateway puede:

- Recibir la solicitud desde la aplicación (mensaje, archivos adjuntos y contexto del cliente).

- Clasificar la petición para identificar qué tipo de IA necesita (LLM, reconocimiento de imágenes, análisis de sentimiento).

- Orquestar el flujo enviando cada parte al modelo más adecuado.

- Aplicar políticas en una sola capa: autenticación, rate limiting, control de costes por tokens y auditoría.

- Unificar la respuesta final (respuesta sugerida, tono recomendado y resultado del análisis de imagen) y devolverla a la aplicación.

La IA Gateway permite que tus equipos traten la inteligencia artificial como un único servicio, en lugar de una colección de integraciones heterogéneas de modelos y agentes de IA en producción.

Beneficios de implementar un IA Gateway

Uno de los principales beneficios de la IA Gateway radica en su capacidad de centralizar el acceso a modelos y servicios inteligentes, además de gobernar, asegurar y optimizar su uso de forma coherente, medible y escalable. A continuación te explicamos cada beneficio en detalle.

Seguridad avanzada y autenticación

Cuando trabajamos en entornos con muchas aplicaciones y agentes que usan modelos de IA, no podemos dejar la seguridad repartida en cada servicio: debe gestionarse de forma centralizada y consistente.

El IA Gateway actúa como un único punto de control donde se aplican reglas de acceso y autenticación para proteger los recursos de IA, tal como un API Gateway lo hace para APIs tradicionales, pero adaptado a los riesgos propios de cargas de trabajo de IA.

Esto se traduce en:

- Autenticación y autorización centralizadas, evitando que cada aplicación implemente sus propias claves o mecanismos.

- Protección contra accesos no autorizados y abuso de modelos.

- Registro y auditoría de accesos que facilitan el cumplimiento de políticas de seguridad.

OWASP (Open Web Application Security Project) resalta lo importante que es proteger las APIs de inteligencia artificial frente a nuevas amenazas. Por eso, han impulsado una iniciativa global llamada OWASP GenAI Security Project enfocada en identificar y abordar distintas vulnerabilidades presentes en aplicaciones basadas en modelos de lenguaje (LLM).

Optimización de la gestión de APIs con IA

Un IA Gateway permite gestionar APIs tradicionales y APIs o endpoints de IA desde un único punto, facilitando una visión unificada del uso, errores, latencia y comportamiento de los servicios, sin tener que instrumentar cada uno por separado.

El siguiente artículo puede interesarte: QA Automation en tus APIs con inteligencia artificial

Integración con Agentes de IA, servidores MCP y modelos LLM

Los agentes de IA (programas que actúan de forma autónoma usando IA) y los modelos LLM (Large Language Models) requieren orquestación para manejar las solicitudes que se distribuyen entre distintos servicios o contextos.

Un IA Gateway posibilita:

- Orquestación de llamadas entre diferentes LLM o motores de IA según reglas de negocio o coste.

- Control y gestión de agentes automatizados que acceden a los mismos recursos.

- Soporte para protocolos estandarizados como MCP (Model Context Protocol), que ayudan a formalizar cómo los agentes consultan herramientas y contexto.

Un IA Gateway se vuelve incluso más importante en este contexto, porque centraliza el control de agentes y modelos, evitando escenarios comunes como:

- Agentes “fuera de control”: agentes que ejecutan demasiadas acciones o llamadas en bucle, generando sobrecarga y consumo excesivo.

- Exposición de datos sensibles: prompts o respuestas que incluyen información privada o interna sin control de acceso y trazabilidad.

- Costes impredecibles: agentes que disparan llamadas a modelos caros sin límites ni visibilidad centralizada.

Rate limiting (limitación de peticiones)

El rate limiting es el proceso de limitar cuántas solicitudes puede emitir un consumidor (aplicación, usuario o agente) a un modelo de IA por unidad de tiempo. Su importancia radica en que, de no cubrirse, los costes pueden dispararse y también aumenta el riesgo de enviar grandes cantidades de datos sensibles sin querer.

Control de costes (Cost control)

Los modelos de IA se facturan muchas veces por consumo (tokens, tiempo de cómputo, etc.). Sin un punto central donde medir y limitar ese consumo, una integración mal diseñada puede generar facturas inesperadas o desequilibrios presupuestales.

Un IA Gateway puede:

- Registrar el uso de tokens o tiempo de inferencia por aplicación o cliente.

- Establecer límites de gasto o alertas automáticas.

- Dirigir peticiones a modelos alternativos más eficientes cuando aplique.

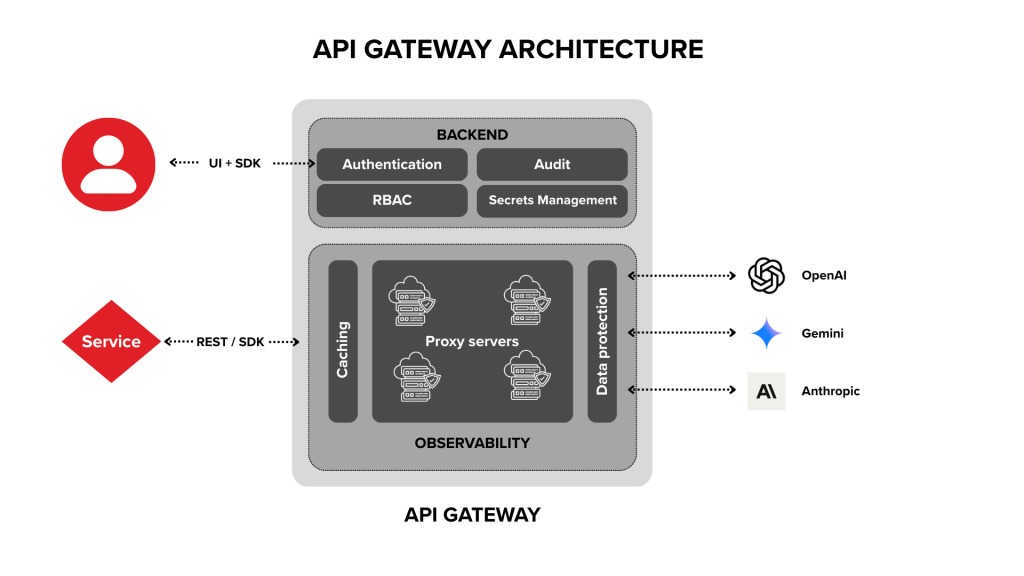

API Gateway Architecture

API Gateway vs IA Gateway

Puede que ya lo hayamos detallado brevemente en puntos anteriores, pero concretamente: ¿Qué tanta diferencia existe entre un API Gateway tradicional y un AI Gateway?

Primero empecemos aplicando un breve resumen de ambos conceptos.

¿Qué es un API Gateway?

Un API Gateway es un punto central de entrada para las APIs de una aplicación. Su función principal es recibir, enrutar y controlar tráfico de APIs, aplicando, igualmente, políticas como seguridad, autenticación, rate limiting y transformaciones de mensaje.

Por ejemplo:

- Un API Gateway gestiona tráfico HTTP/REST.

- Aplica autenticación (OAuth/JWT).

- Realiza balanceo y enrutamiento.

- Registra métricas de uso estándar.

Por otro lado… ¿Qué es lo que lo separa de la IA Gateway?

Un AI Gateway se puede ver como una evolución del API Gateway, sin embargo, además de las funciones tradicionales de un API Gateway, un AI Gateway ofrece:

- Entendimiento de tráfico de IA: reconocimiento de patrones de consumo específicos de modelos y agentes.

- Orquestación de modelos de IA: enruta peticiones entre distintos LLMs según reglas de coste, latencia o calidad.

- Observabilidad específica de IA: métricas como tokens usados, tiempos de inferencia o costes por modelo.

- Integración de agentes de IA: supervisa y controla agentes autónomos que usan IA.

- Políticas adaptadas a IA: rate limiting y control de costes específicos para uso de modelos.

En resumen: Cumple con los mismos principios y puede usarse de manera similar, pero expande su rango de operabilidad, incorporando cargas de trabajo de inteligencia artificial y APIs también de IA.

Comparativa: API Gateway vs IA Gateway

A continuación mostramos una tabla que resume los alcances de cada uno:

| Característica | API Gateway | IA Gateway |

| Gestión de APIs | Sí | Sí |

| Control de tráfico | Básico | Inteligente y dinámico |

| Observabilidad | Limitada | AI observability (tokens, prompts, costes) |

| Seguridad | APIs y servicios | APIs + agentes de IA |

| Orquestación de LLMs | No | Sí |

| Optimización de costes IA | No | Sí |

¿Esto quiere decir que es necesario optar por un modelo de IA Gateway en lugar de un API Gateway? La respuesta depende por completo de cuánto se encuentre incorporada la Inteligencia Artificial en tu arquitectura empresarial.

Si solo necesitas rutar y controlar APIs tradicionales, un API Gateway es suficiente.

Por otro lado, si trabajas con modelos de IA, agentes automatizados o aplicaciones que dependen de inferencias inteligentes, un AI Gateway ofrece capacidad de gobernanza y optimización especializada que un API Gateway no provee por sí mismo.

Plataformas y tecnologías recomendadas

A continuación mostramos algunas plataformas y soluciones eficaces y confiables que te permitirán gestionar, asegurar y optimizar el tráfico de tus APIs, aplicaciones y modelos de inteligencia artificial.

WSO2 AI Gateway

WSO2 API Manager forma parte de la suite de WSO2 API Manager, una plataforma open source para gestión de APIs y tráfico inteligente.

Este componente está diseñado para centralizar y gobernar el tráfico de IA desde un solo punto, aplicando seguridad, análisis de uso y políticas de control.

Qué ofrece:

- Integración con múltiples proveedores de IA (OpenAI, Google Gemini, Mistral AI, entre otros), permitiendo enrutar y balancear tráfico entre modelos.

- Control de costes y observabilidad, con métricas de uso, latencia y patrones de tráfico para optimizar operaciones.

- AI Guardrails y seguridad avanzada, con validaciones de prompts, control de outputs y compliance.

- Gestión de agentes y MCP Gateway, que convierte APIs existentes en recursos seguros accesibles por agentes inteligentes bajo un modelo gobernado.

- Políticas de rate limiting y cuotas de tokens para proteger recursos y evitar abuso.

Gravitee AI Agent Management

Gravitee es una plataforma de API Management open source que ha evolucionado para incorporar capacidades de AI Agent Management y políticas LLM dentro de su catálogo de gestión.

Características:

- Agent Mesh: suite integrada que permite definir, administrar y proteger comunicaciones entre agentes inteligentes mediante protocolos como A2A (Agent-to-Agent).

- MCP Proxy y LLM Proxy: capas que permiten gestionar cómo los agentes consumen servicios de IA y modelos, con políticas y seguridad aplicadas de forma consistente.

- Control de acceso, seguridad y observabilidad para comunicaciones entre agentes y hacia/desde modelos de IA.

- Catálogo centralizado de agentes que facilita descubrimiento, gobernanza y control de interacciones entre agentes.

Apache APISIX

Apache APISIX es un API Gateway open source de alto rendimiento que también sirve como base para extender políticas de AI Gateway, gracias a su arquitectura modular y capacidades de plugin.

¿Qué capacidades ofrece?

- Rico conjunto de plugins para autenticación, balanceo, limitación de tasa, observabilidad y seguridad a través de una arquitectura extensible.

- Soporte para enrutamiento dinámico y hot-loading de plugins para adaptar el comportamiento del gateway sin reiniciar servicios.

- Escalabilidad y rendimiento óptimo para cargas de tráfico de API y servicios inteligentes, facilitando construcciones donde la IA convive con APIs tradicionales.

El siguiente artículo puede interesarte: Apache Apisix: El API gateway cloud-native de alto rendimiento para arquitecturas de microservicios

Kong AI Gateway

Kong AI Gateway es una solución diseñada para gestionar, securizar y optimizar de forma centralizada el tráfico hacia modelos de IA (LLMs) y recursos asociados como MCP Servers. Está construido sobre la infraestructura de Kong Gateway y añade un conjunto de capacidades especializadas para casos de IA en producción

- Multi-LLM y proveedor unificado: Permite integrar y enrutar solicitudes hacia múltiples proveedores de modelos (OpenAI, AWS Bedrock, GCP Vertex y otros) desde una única API, simplificando la adopción y permitiendo cambiar de proveedor sin modificar código de aplicación.

- Seguridad y guardrails de contenido: Integra capacidades para moderar y proteger el contenido que se envía a los modelos mediante políticas de guardrails, listas de control semántico y sanitización de PII (datos sensibles), apoyando el cumplimiento y reduciendo riesgos de contenido inapropiado o filtración de datos.

- Automatización de pipelines RAG y MCP: Facilita la construcción de pipelines de Recuperación Augmentada con Generación (RAG) y la exposición/gestión de MCP Servers, permitiendo implementar y gobernar flujos complejos sin necesidad de construir infraestructura de soporte desde cero.

No-code y plugins integrados: Ofrece integración mediante plugins que no requieren código (por ejemplo, AI Proxy, Prompt Guard, Prompt Template), acelerando la adopción y reduciendo la carga de ingeniería para habilitar políticas de IA.

Mejores prácticas para implementar una IA Gateway

- Empieza por rutas críticas y estandariza el acceso: Enruta primero las llamadas a LLM de mayor impacto (apps core, agentes internos) por el gateway para unificar políticas y observabilidad sin bloquear al resto.

- Define planes de consumo (por equipo o app) y aplica límites por tokens y requests: Limitar solo por requests no basta; usa también cuotas por tokens para evitar picos de coste y reparto injusto.

- Activa caché donde tenga sentido (respuestas repetibles): Para prompts o consultas recurrentes, cachear reduce latencia y llamadas pagadas al proveedor.

- Incorpora Guardrails como política: Aplica controles de contenido/seguridad (por ejemplo, clasificación de prompts) en el gateway para que sean consistentes.

- Mide lo que importa en IA y convierte métricas en decisiones: Instrumenta las métricas operativas y de IA (errores, latencia, consumo) y úsalas para ajustar rutas, límites y caché.

Casos de uso y ejemplos

A continuación, listamos algunos ejemplos de IA Gateways aplicados en industrias con el objetivo de mejorar procesos a través de la inteligencia artificial.

Estos casos han sido destacados por Coralogix (herramienta de observabilidad), y también por enfoques más técnicos y operativos documentados por Apache APISIX (casos esenciales de AI Gateway) y Solo.io (optimización de GenAI en producción):

- Salud (Healthcare) — diagnóstico asistido por IA (Coralogix): un AI Gateway permite que un hospital o una clínica conecte de forma controlada aplicaciones internas (por ejemplo, un visor clínico) con modelos que analizan imágenes médicas. En vez de que cada sistema “hable directamente” con el modelo, el gateway centraliza la integración y facilita la aplicación de reglas como la autenticación, la trazabilidad y el control de uso. Esto acelera el flujo porque la app solo consume un endpoint y el gateway se encarga de enrutar la petición al modelo correcto.

- Finanzas — detección de fraude en tiempo real (Coralogix): en un banco o fintech, cada transacción puede pasar por un flujo de IA que detecta patrones anómalos (por ejemplo, comportamiento inusual de compra o intentos de acceso sospechosos). El AI Gateway ayuda a estandarizar ese “paso por IA” como parte del pipeline de autorización, y aporta control operativo: quién llama al modelo, con qué frecuencia, y cómo se registra el evento para auditoría. Así se evita que cada equipo implemente su propio motor de fraude sin control común.

- Enrutamiento inteligente y resiliencia entre modelos (Apache APISIX): cuando una organización usa varios modelos (por coste, precisión o disponibilidad), el AI Gateway puede tomar decisiones de enrutamiento en tiempo real. Por ejemplo: consultas simples (FAQ, clasificación básica) se envían a un modelo económico, mientras que casos complejos (redacción legal, análisis avanzado) se envían a un modelo más potente. Además, si un proveedor se degrada o falla, el gateway puede aplicar fallback hacia otro modelo, manteniendo la continuidad del servicio sin tener que modificar cada aplicación cliente.

- Optimización de costes con semantic caching (Solo.io): en asistentes internos o bots de soporte, muchas preguntas se repiten (“¿Cómo reinicio mi contraseña?”, “¿Cuál es la política de vacaciones?”). Con un AI Gateway, se puede implementar caching semántico: si una nueva consulta es equivalente a una anterior, el sistema puede reutilizar la respuesta ya generada en lugar de volver a invocar el modelo. Esto reduce latencia, baja consumo de tokens y hace que la IA sea más viable económicamente cuando el volumen de usuarios crece.

- Control de consumo con rate limiting y presupuestos (Apache APISIX): cuando la IA se vuelve parte de procesos críticos, también se vuelve un punto de gasto y riesgo. Un AI Gateway permite imponer límites por usuario, aplicación o equipo (por ejemplo, “máximo X requests/minuto” o “máximo Y tokens/día”). Esto evita que un bug, un mal prompt o un abuso intencional dispare el consumo. También facilita operar IA como un servicio gobernado: con cuotas claras, previsibilidad de coste y control centralizado sin bloquear la innovación de cada equipo.

Preguntas frecuentes sobre puertas de enlace de IA

Las siguientes preguntas han sido respondidas por Alfredo Prats, Head of Technical Delivery de Chakray España:

¿Qué es exactamente un AI Gateway?

Un AI Gateway es una plataforma de middleware especializada que facilita la integración, gestión y gobernanza de servicios de inteligencia artificial —incluidos modelos de lenguaje (LLMs) y APIs de IA— conectando aplicaciones con estos servicios a través de un punto central de control.

Un AI Gateway es un componente de software que actúa de intermediario entre las aplicaciones consumidoras y los motores de inteligencia artificial, aplicando un modelo de gobernanza común. Este modelo de gobernanza nos permite unificar el uso de los diferentes motores de IA en un punto central, determinar el motor adecuado, mantener sus costes bajo control y filtrar aquella información sensible antes de ser enviada.

¿Un IA Gateway sustituye a un API Gateway?

No. Lo complementa o amplía cuando se incorporan servicios de IA.

No, son complementarios. El API Gateway gobierna nuestras APIs internas y externas y el AI Gateway gobierna el uso de los motores de IA certificados por la empresa. Por último, el API Gateway puede incorporar en su proceso de mediación el uso del AI Gateway.

¿Un AI Gateway funciona con múltiples proveedores de IA?

Sí. La mayoría de soluciones de AI Gateway soportan múltiples proveedores de inferencia, incluyendo modelos de terceros o clústeres internos, permitiendo un uso unificado sin acoplarse a un solo vendedor.

Sí, la mayoría de soluciones de AI Gateway son capaces de integrarse con múltiples motores de IA, tanto internos como externos.

¿Sirve solo para LLMs?

No. También gestiona agentes de IA, APIs inteligentes y microservicios con IA.

¿Puede un AI Gateway integrarse con servicios empresariales existentes?

Sí. Muchas plataformas de AI Gateway están diseñadas para integrarse con infraestructuras empresariales existentes (como API Management de nubes públicas) y aplicar políticas de seguridad y gobernanza que ya usas en tus sistemas.

Sí, el AI Gateway en muchas ocasiones forma parte del ecosistema de API Management de la compañía, permitiendo diseñar un modelo de gobernanza común tanto para el consumo de APIs como el consumo de servicios de IA.

¿Por qué necesito un AI Gateway si ya tengo un API Gateway?

Aunque un API Gateway gestiona tráfico API general, no está optimizado para cargas de trabajo de IA. Un AI Gateway ofrece características específicas como:

- Observabilidad de métricas de IA (tokens, inferencias).

- Gestión de múltiples modelos de IA.

- Políticas adaptadas a agentes y consumo de IA.

Trabajar con los diferentes motores de IA requiere de un cambio de paradigma. A diferencia de un API Gateway, que trabaja en base a peticiones, los AI Gateways están diseñados para trabajar con tokens, facilitando el gobierno de los diferentes motores de IA certificados por las compañías.

Conclusión

Un AI Gateway es la pieza más importante para escalar el uso de LLMs, agentes de IA y APIs inteligentes en producción. Entre lo más destacado, centraliza seguridad, observabilidad y control, además de facilitar la integración entre aplicaciones y múltiples proveedores y modelos.

Si deseas evaluar tus opciones y plataformas para incorporar la IA en tu organización, en Chakray podemos asesorarte. Contáctanos hoy mismo y da el siguiente paso hacia una adopción de IA segura, escalable y con control.